Aufgabe: Verbessern der Datenqualität in grossen Datenbeständen

Wer möchte nicht die Qualität seiner Daten verbessern? Doch die Aufgabe ist zu gross. Unmöglich können alle Daten auf einmal korrigiert, verbessert, bereinigt werden. Da bietet sich das Bereinigen der Daten in Etappen an.

Ausgangssituation

Die Situation ist typisch: Die Datenmengen sind gross. Dabei weisen die Daten unterschiedliche Qualität auf. Sie soll verbessert werden. Aber nur Spezialisten, welche die Daten kennen, sind überhaupt in der Lage, die Daten zu verbessern. Und diese haben anderes zu tun. Höchstens ab und zu können sie sich mit ihren Daten befassen. Als Folge davon dauert die Bereinigungsphase sehr lange.

Dann kommt ein weiteres Problem hinzu. Die Bereinigungsphase dauert Wochen oder sogar Monate. Während dieser Zeit bleiben die Systeme nicht still. Sie werden weiter genutzt, ihre Daten verändert. Die Anwender verändern oder löschen bestehende Datensätze und fügen neue hinzu. Die Systeme leben weiter und gleichzeitig wollen wir die Datenqualität insgesamt erhöhen.

Wie können wir die Aufgabe in diesem Fall lösen?

Lösung: Bereinigen von Daten in Etappen

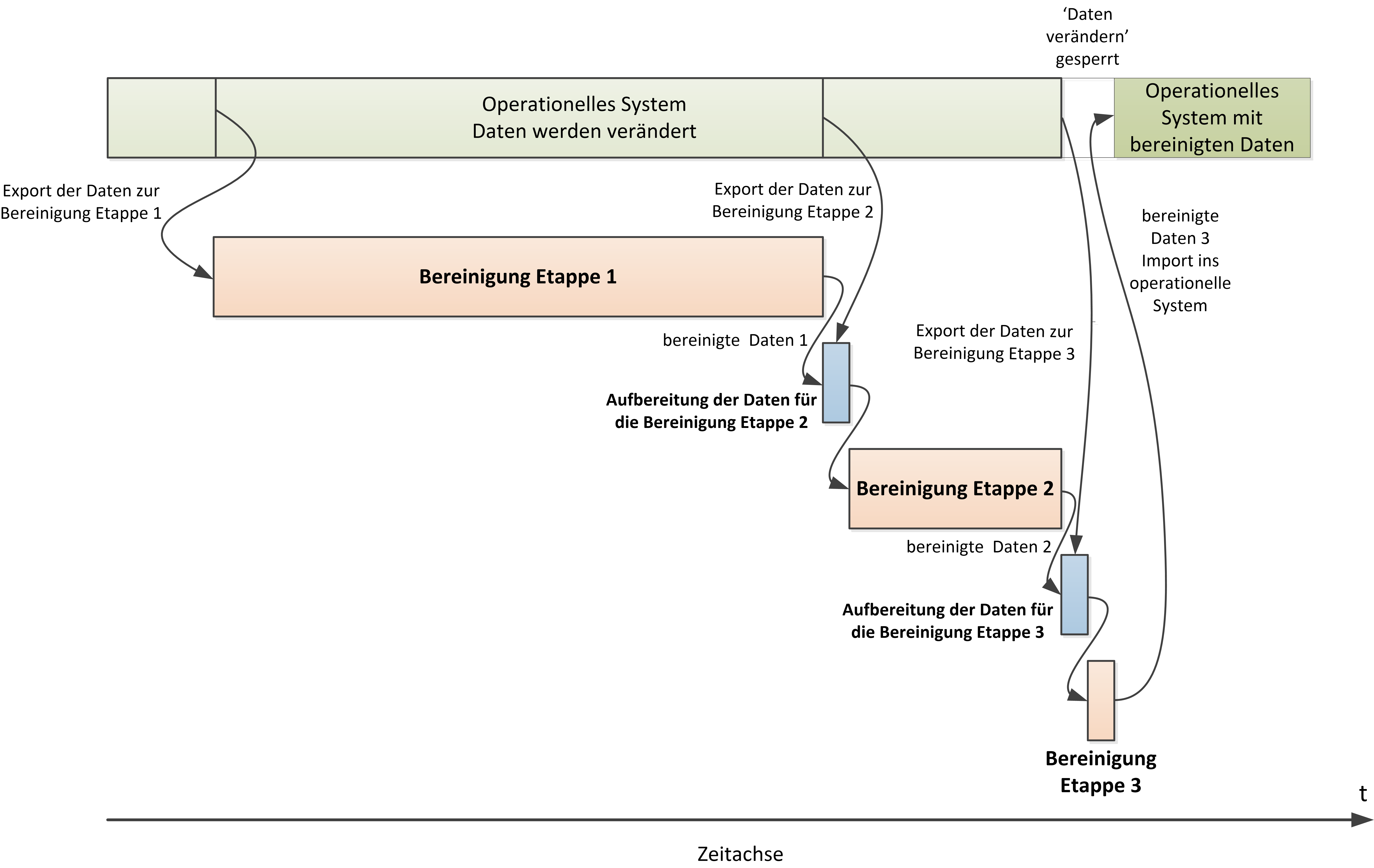

Am einfachsten können wir die Aufgabe lösen, wenn wir das Bereinigen der Daten vom laufenden System abtrennen. Die Daten, welche die Spezialisten verbessern sollen, exportieren wir aus dem laufenden System. Bewährt haben sich dafür einfache Excel-Listen. Die Daten werden dorthin exportiert. Die Spezialisten ergänzen und korrigieren die Daten darauf in diesen Listen. Sie haben dafür genügend Zeit, da die Arbeit vom laufenden Betrieb unabhängig ist.

Sind sie mit der Arbeit fertig, so liefern sie die bereinigten Daten ab. Nur in der Zwischenzeit haben sich die Daten auf den laufenden Systemen auch verändert. Vielleicht sind einige Korrekturen schon in den aktiven Daten enthalten. Wahrscheinlicher ist aber, dass neue Daten dazu gekommen sind.

Deshalb ist es ausgeschlossen, die bereinigten Daten einfach in das laufende System zu übernehmen. Alle Veränderungen gingen verloren. Es bleibt nichts anderes übrig, als die Daten erneut zu exportieren. Jetzt müssen wir die neu exportierten Daten mit den bereinigten Daten vergleichen. Die Änderungen müssen nochmals von den Spezialisten überprüft und ggf. korrigiert und ergänzt werden. Der Vorteil dabei ist: Die Datenmenge ist viel kleiner geworden. Die Arbeit lässt sich in viel kürzerer Zeit bewältigen.

Dieses Verfahren wenden wir so oft an, bis die Zeit für das Bereinigen der Daten nur noch einen Tag dauert. Während dieses Tags blockieren wir das System für das Löschen, Ändern und Einfügen neuer Daten.

Nach diesem Tag können wir die in Etappen bereinigten Daten ins laufende System übernehmen. Die Aufgabe ist gelöst. Schematisch ist die Aufgabenstellung in der Figur 1 abgebildet.

Software Tool zum Bereinigen von Daten in Etappen

Ganz ohne Software Unterstützung funktioniert das Verfahren nicht. Es braucht ein Software Tool zur Verwaltung der Bereinigung, welches die folgenden Eigenschaften besitzt:

- Einlese Funktion – System:

Die Daten aus dem laufenden System werden in das Tool eingelesen. - Export Funktion -Bereitstellen der Daten:

Das Tool stellt die Daten für das Bereinigen durch die Spezialisten bereit. Beispielsweise erstellt es Excel-Listen, welche diese Daten enthalten.

- Einlese Funktion – bereinigte Daten:

Die bereinigten Daten werden in das Tool zur Verwaltung der Bereinigung eingelesen. - Vergleichsfunktion:

Das Tool vergleicht die im nächsten Schritt eingelesenen mit den früher eingelesenen Daten. Darauf vergleicht es die beiden Datenstände. Zum Schluss bildet es die Differenz. Es stellt somit die Differenzdaten für die nächste Bereinigungsetappe bereit. - Export Funktion – System:

Das Tool exportiert die bereinigten Daten kontrolliert in das laufende System.

CrowTen verfügt mit dem Data AppKit über ein Software Tool für diese Aufgabe. Das Bereinigen in Etappen wurde erfolgreich bei den Schweizerischen Bundesbahnen zur Übernahme der Daten des Gotthard Basistunnels erfolgreich eingesetzt.